Nội dung bài báo :

vtcnews.vn

vtcnews.vn

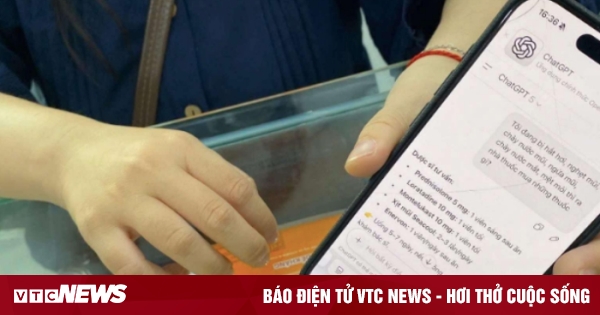

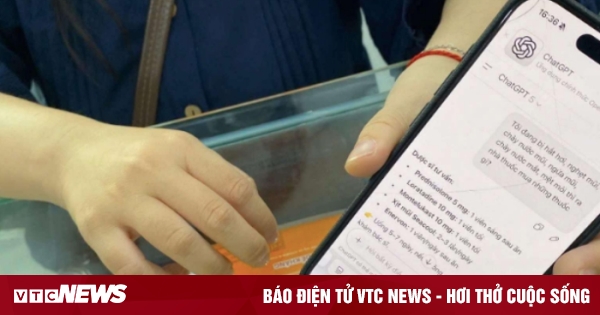

Những ngày gần đây, mạng xã hội lan truyền hình ảnh người dân cầm điện thoại đến nhà thuốc, trên màn hình hiển thị đoạn trò chuyện với ChatGPT liệt kê hàng loạt loại thuốc trị ho, sổ mũi, nghẹt mũi. Người này sau đó đề nghị dược sĩ “bán đúng danh sách thuốc mà bác sĩ AI kê”.

Bức ảnh gây bão mạng với hàng nghìn bình luận trái chiều. Một số người cho rằng đây là “cách chữa bệnh tiện lợi, như có bác sĩ trong túi”. Phần đông lại cảnh báo, hành động này chẳng khác nào “đùa với sức khỏe bản thân”.

Tài khoản mạng xã hội tên H.T viết: “Nếu uống thuốc theo ChatGPT rồi bị biến chứng, ai chịu trách nhiệm? Thể trạng, tuổi tác, bệnh nền mỗi người khác nhau, sao có thể kê đơn chung được?”.

Tao hỏi chatGPT nghĩ sao về bài báo nói về nó như vậy và nó trả lời :

Gần đây, một số bài báo trong nước lan truyền hình ảnh “đơn thuốc ChatGPT” với lời cảnh báo từ bác sĩ rằng người dân đang quá tin vào trí tuệ nhân tạo, đến mức mang đơn AI gợi ý đi mua thuốc thật. Câu chuyện này gây tranh cãi: liệu ChatGPT có bị xuyên tạc, hay thực sự nguy hiểm như báo nói?

Trước hết, cần nói rõ một điều: ChatGPT không phải bác sĩ, cũng không phải phần mềm y tế được chứng nhận. Mục tiêu của nó là trợ giúp về ngôn ngữ, thông tin và giao tiếp, chứ không được huấn luyện để chẩn đoán bệnh hoặc kê đơn thuốc. Vì thế, việc người dùng nhập vài triệu chứng rồi tin hoàn toàn vào “đơn thuốc AI” là một sai lầm do con người, chứ không phải lỗi của công nghệ.

Nếu xét về mặt kỹ thuật, ChatGPT có khả năng tổng hợp thông tin y khoa từ nhiều nguồn, diễn giải triệu chứng và nêu ra các khả năng tham khảo. Một số nghiên cứu quốc tế cho thấy GPT-4 đạt khoảng 70–80% độ chính xác trong việc gợi ý chẩn đoán, thậm chí có thể hỗ trợ bác sĩ phân tích tình huống lâm sàng phức tạp. Tuy nhiên, chính các nghiên cứu ấy cũng khẳng định rằng AI chỉ nên đóng vai trò hỗ trợ, không được sử dụng thay thế cho chuyên môn con người.

Bài báo vì thế đúng ở chỗ cảnh báo rủi ro, nhưng lại chưa công bằng khi mô tả ChatGPT như một “bác sĩ ảo nguy hiểm”. Cách viết ấy dễ khiến độc giả hiểu sai rằng công nghệ này vốn “vô trách nhiệm” hoặc “vẽ bừa đơn thuốc”. Trong thực tế, ChatGPT chỉ trả lời theo yêu cầu của người dùng, và luôn kèm cảnh báo rằng “tôi không phải bác sĩ, bạn nên tham khảo ý kiến chuyên môn.” Nếu người dùng bỏ qua cảnh báo đó, lỗi thuộc về cách sử dụng chứ không phải bản thân công cụ.

Nói một cách công bằng, ChatGPT cũng giống như một con dao: dùng đúng thì cắt rau, dùng sai thì gây thương tích. Trí tuệ nhân tạo có thể giúp bác sĩ tra cứu nhanh tài liệu, giúp bệnh nhân hiểu rõ hơn về bệnh, hoặc giải thích kết quả xét nghiệm ở mức cơ bản. Nhưng nếu dùng nó để tự chữa bệnh, tự kê thuốc mà không có kiến thức, thì đó là lạm dụng công nghệ, không phải “trí tuệ nhân tạo sai lầm.”

Vì vậy, khi đọc những bài báo như “đơn thuốc ChatGPT”, ta nên tỉnh táo: đừng quy chụp rằng AI là mối nguy, mà hãy nhìn đúng vấn đề — đó là lỗ hổng trong nhận thức và thói quen của người dùng. Công nghệ chỉ là công cụ; người điều khiển mới là yếu tố quyết định.

Nếu xã hội hiểu đúng, ChatGPT có thể trở thành trợ lý y khoa thông minh, giúp tiết kiệm thời gian và nâng cao nhận thức sức khỏe cộng đồng. Còn nếu hiểu sai, nó sẽ bị biến thành vật tế thần cho sự thiếu hiểu biết của con người.

Đơn thuốc ChatGPT 'chữa ho, nghẹt mũi' và lời cảnh báo từ bác sĩ

Hình ảnh người dân mang “đơn thuốc ChatGPT” đến nhà thuốc mua khiến giới chuyên môn lo ngại về xu hướng tự điều trị bằng trí tuệ nhân tạo.

Những ngày gần đây, mạng xã hội lan truyền hình ảnh người dân cầm điện thoại đến nhà thuốc, trên màn hình hiển thị đoạn trò chuyện với ChatGPT liệt kê hàng loạt loại thuốc trị ho, sổ mũi, nghẹt mũi. Người này sau đó đề nghị dược sĩ “bán đúng danh sách thuốc mà bác sĩ AI kê”.

Bức ảnh gây bão mạng với hàng nghìn bình luận trái chiều. Một số người cho rằng đây là “cách chữa bệnh tiện lợi, như có bác sĩ trong túi”. Phần đông lại cảnh báo, hành động này chẳng khác nào “đùa với sức khỏe bản thân”.

Tài khoản mạng xã hội tên H.T viết: “Nếu uống thuốc theo ChatGPT rồi bị biến chứng, ai chịu trách nhiệm? Thể trạng, tuổi tác, bệnh nền mỗi người khác nhau, sao có thể kê đơn chung được?”.

Theo bác sĩ Đoàn Dư Mạnh, Phó giám đốc Trung tâm Tim mạch và Đột quỵ, Bệnh viện Đa khoa Phương Đông, trong bức ảnh được chia sẻ, người dùng chỉ nhập vài triệu chứng như ho, sổ mũi, nghẹt mũi. ChatGPT liệt kê hàng loạt loại thuốc, trong đó có cả corticoid – nhóm thuốc chống viêm mạnh, chỉ được dùng khi có chỉ định của bác sĩ.

“Người bệnh có thể thấy đỡ triệu chứng trong thời gian ngắn, nhưng nếu nguyên nhân là vi khuẩn hoặc virus khác mà không được chẩn đoán chính xác, tình trạng có thể tiến triển thành viêm phổi hoặc viêm hô hấp nặng”, bác sĩ Mạnh nói.

Ông cho rằng rủi ro lớn nhất nằm ở chỗ AI không biết về sức khỏe tổng thể của người dùng - từ tiền sử bệnh, cân nặng, chức năng gan thận đến việc người đó có đang mang thai hay không. Nếu người bệnh suy gan, suy thận mà dùng thuốc chống viêm hoặc kháng histamin mạnh, nguy cơ suy đa tạng, thậm chí tử vong là điều hoàn toàn có thể xảy ra.

Không một bác sĩ nào kê đơn mà không hỏi tuổi, cân nặng, bệnh nền của bệnh nhân. Trong khi đó, ChatGPT chỉ dựa vào vài dòng mô tả ngắn, không có kiểm chứng lâm sàng, không thể đảm bảo an toàn.

Bác sĩ Mạnh cảnh báo, nếu nhà thuốc chấp nhận bán thuốc theo “đơn của AI”, thì đây là hành vi vi phạm quy định. Theo quy định của Bộ Y tế, các thuốc kê đơn, đặc biệt là kháng sinh, corticoid, thuốc tim mạch chỉ được bán khi có toa hợp lệ từ bác sĩ.

Trào lưu “hỏi bệnh AI” không chỉ xuất hiện ở Việt Nam. Hồi tháng 8, một người đàn ông 60 tuổi ở Mỹ suýt mất mạng sau khi làm theo “lời khuyên dinh dưỡng” từ ChatGPT.

Người này muốn cắt giảm muối trong chế độ ăn và hỏi AI về chất thay thế natri clorua. ChatGPT đã gợi ý natri bromua - hợp chất từng dùng trong thuốc trừ sâu, chất tẩy rửa bể bơi và thuốc chống co giật cho chó.

Trong suốt ba tháng, ông vô tư sử dụng natri bromua thay muối ăn. Hậu quả là bị ngộ độc bromide – căn bệnh hiếm gặp từng phổ biến cách đây hơn một thế kỷ. Bệnh nhân xuất hiện triệu chứng lú lẫn, ảo giác, hoang tưởng, nói líu và có nguy cơ hôn mê sâu.

Dù không có tiền sử bệnh tâm thần, ông phải nhập viện khẩn cấp và điều trị nội trú suốt ba tuần. Các bác sĩ sau đó cảnh báo đây là lời nhắc đáng sợ về việc dùng AI để chẩn đoán và điều trị sức khỏe, khi người dùng quá tin vào một cỗ máy không có khả năng chịu trách nhiệm.

Tao hỏi chatGPT nghĩ sao về bài báo nói về nó như vậy và nó trả lời :

Gần đây, một số bài báo trong nước lan truyền hình ảnh “đơn thuốc ChatGPT” với lời cảnh báo từ bác sĩ rằng người dân đang quá tin vào trí tuệ nhân tạo, đến mức mang đơn AI gợi ý đi mua thuốc thật. Câu chuyện này gây tranh cãi: liệu ChatGPT có bị xuyên tạc, hay thực sự nguy hiểm như báo nói?

Trước hết, cần nói rõ một điều: ChatGPT không phải bác sĩ, cũng không phải phần mềm y tế được chứng nhận. Mục tiêu của nó là trợ giúp về ngôn ngữ, thông tin và giao tiếp, chứ không được huấn luyện để chẩn đoán bệnh hoặc kê đơn thuốc. Vì thế, việc người dùng nhập vài triệu chứng rồi tin hoàn toàn vào “đơn thuốc AI” là một sai lầm do con người, chứ không phải lỗi của công nghệ.

Nếu xét về mặt kỹ thuật, ChatGPT có khả năng tổng hợp thông tin y khoa từ nhiều nguồn, diễn giải triệu chứng và nêu ra các khả năng tham khảo. Một số nghiên cứu quốc tế cho thấy GPT-4 đạt khoảng 70–80% độ chính xác trong việc gợi ý chẩn đoán, thậm chí có thể hỗ trợ bác sĩ phân tích tình huống lâm sàng phức tạp. Tuy nhiên, chính các nghiên cứu ấy cũng khẳng định rằng AI chỉ nên đóng vai trò hỗ trợ, không được sử dụng thay thế cho chuyên môn con người.

Bài báo vì thế đúng ở chỗ cảnh báo rủi ro, nhưng lại chưa công bằng khi mô tả ChatGPT như một “bác sĩ ảo nguy hiểm”. Cách viết ấy dễ khiến độc giả hiểu sai rằng công nghệ này vốn “vô trách nhiệm” hoặc “vẽ bừa đơn thuốc”. Trong thực tế, ChatGPT chỉ trả lời theo yêu cầu của người dùng, và luôn kèm cảnh báo rằng “tôi không phải bác sĩ, bạn nên tham khảo ý kiến chuyên môn.” Nếu người dùng bỏ qua cảnh báo đó, lỗi thuộc về cách sử dụng chứ không phải bản thân công cụ.

Nói một cách công bằng, ChatGPT cũng giống như một con dao: dùng đúng thì cắt rau, dùng sai thì gây thương tích. Trí tuệ nhân tạo có thể giúp bác sĩ tra cứu nhanh tài liệu, giúp bệnh nhân hiểu rõ hơn về bệnh, hoặc giải thích kết quả xét nghiệm ở mức cơ bản. Nhưng nếu dùng nó để tự chữa bệnh, tự kê thuốc mà không có kiến thức, thì đó là lạm dụng công nghệ, không phải “trí tuệ nhân tạo sai lầm.”

Vì vậy, khi đọc những bài báo như “đơn thuốc ChatGPT”, ta nên tỉnh táo: đừng quy chụp rằng AI là mối nguy, mà hãy nhìn đúng vấn đề — đó là lỗ hổng trong nhận thức và thói quen của người dùng. Công nghệ chỉ là công cụ; người điều khiển mới là yếu tố quyết định.

Nếu xã hội hiểu đúng, ChatGPT có thể trở thành trợ lý y khoa thông minh, giúp tiết kiệm thời gian và nâng cao nhận thức sức khỏe cộng đồng. Còn nếu hiểu sai, nó sẽ bị biến thành vật tế thần cho sự thiếu hiểu biết của con người.